Ist künstliche Intelligenz intelligent? Oder kann sie es werden?

Der bekannte Schriftsteller Daniel Kehlmann («Die Vermessung der Welt») hat letztes Jahr mit einem Sprachalgorithmus (CTRL) in Silicon Valley zusammen den Versuch unternommen, eine Kurzgeschichte zu schreiben. Fasziniert und gleichzeitig kritisch berichtet er über dieses aufschlussreiche Experiment.

CTRL

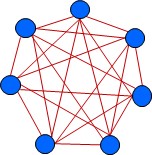

Das Programm CTRL ist ein typisches corpusbasiertes KI-System, d.h. ein System mit einer grossen Datensammlung – dem Corpus – und einem statistisch funktionierenden Auswertungsalgorithmus. Konkret haben die Betreiber den Corpus von CTRL mit Hunderttausenden von Büchern, Zeitungen und Online-Foren gefüttert, wodurch das System auf ein Gedächtnis aus Abermillionen von Sätzen zurückgreifen kann. Die Auswertung dieses Datenschatzes erfolgt aufgrund der Wahrscheinlichkeit: Wenn statistisch auf Wort A das Wort B das wahrscheinlichste ist, bringt das System nach Wort A auch das Wort B. Dank des immensen Corpus kann sich das System darauf verlassen, dass A nach B für uns durchaus eine wohlklingende Fortsetzung des Textes ist. Die schiere Wahrscheinlichkeit ist ist das Prinzip jeder korpusbasierten KI.

Natürlich ist anzunehmen, dass die Betreiber nicht nur die unmittelbaren Nachbarwörter berücksichtigen, sondern die Tiefenschärfe um das Ausgangswort weitreichender einstellen, also mehr Kontext berücksichtigen, doch stets gilt auch bei der Fortschreibung des gemeinsamen Textes durch Kehlmann und CTRL, dass der Algorithmus den bisher geschriebenen Text mit seinem grossen Corpus vergleicht und dann die Fortsetzung basierend auf der Wahrscheinlichkeit in seinem Korpus vorschlägt. Dadurch wird uns die Fortsetzung stets irgendwie vertraut und möglich vorkommen. – Wird sie aber auch sinnvoll sein? Wir kommen hier an die Grenzen jeder corpusbasierten Intelligenz: Das Wahrscheinlichste ist nicht immer das Beste.

Die Grenzen von CTRL

Daniel Kehlmann beschreibt die gemeinsame kreative Welt, die er zusammen mit dem Programm CTRL erkundet hat, gleichzeitig fasziniert und kritisch. Kritisch vermerkt er u.a. folgende Mängel:

a) Abstürze des Algorithmus

Beim Experiment ist es nicht gelungen, eine Kurzgeschichte über eine bestimmte Länge weiterzuschreiben; offenbar war dann der Algorithmus rechnerisch nicht in der Lage, die Informationen der bisherigen Geschichte kohärent mit dem Corpus zusammenzubringen. Sobald die Geschichte über einige Sätze hinausging, stürzte das Programm regelmässig unrettbar ab – Ende der Gesichte.

Meines Erachtens ist das kein KO-Kriterium, denn Abstürze eines neuen Programms sind stets zu erwarten (ich weiss, wovon ich spreche … ). Zudem erwecken solche Abstürze stets den Eindruck, als könnten sie mit noch besserer Hardware und robusteren Algorithmen überwunden werden.

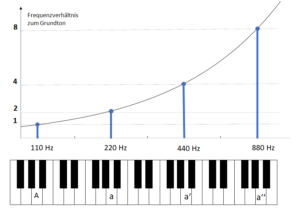

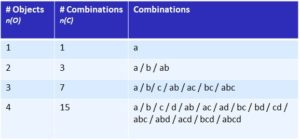

Doch dies ist m.E. hier nicht der Fall. Ich glaube vielmehr, dass diese Abstürze einen grundsätzlichen Schwachpunkt der corpusbasierten KI offenbaren, der auch mit verbesserter Hardware und besseren Auswertungsalgorithmen nicht angegangen werden kann. Der Mangel liegt vielmehr prinzipiell in der wahrscheinlichkeitsbasierten Anlage dieser corpusbasierten Programme. Je mehr Kontext (Tiefenschärfe) sie berücksichtigen müssen, umso grösser muss ihr Corpus werden. Doch der Bedarf an Daten und Rechenpower wächst, wenn es um die Vergrösserung des Kontexts geht, nicht linear, sondern exponentiell. Selbst wenn der riesige Corpus und die immense Rechenpower von CTRL weiter vergrössert werden würden, stösst ein solches Programm systembedingt immer und rasch an seine Grenzen.

Um Sinn und Bedeutung einzufangen, braucht es grundsätzlich andere Methoden, solche, die Bedeutung nicht indirekt aus statistischen Daten ausmitteln, sondern sie direkt repräsentieren und behandeln. Erst dann können die Programme direkt mit Bedeutung umgehen.

b) Zweitverwertung

CTRL kennt nichts Neues, dafür Abermillionen alter Sätze. Dies birgt die Gefahr des «Garbage In, Garbage Out». Wenn Fehler oder Schwächen in den bisherigen Texten vorhanden sind, können sie auch in den Sätzen von CTRL auftauchen. Diese Gefahr ist zwar an sich klein, denn durch die grosse Menge an Sätzen wird es wahrscheinlicher, dass gleiche korrekte Sätze auftauchen als gleiche falsche, und somit wird CTRL sicher nur grammatikalisch, oder mindestens umgangssprachlich korrekte Sätze liefern. Doch trifft dies auch auf den Inhalt zu?

Wenn mehrere Menschen den gleichen Fehler machen, wird er dadurch zwar nicht korrekt, aber für eine corpusbasierte KI wird er so salonfähig. Rechtsextreme Messanger wird CTRL zwar kaum als bevorzugte Quelle benutzen, doch es geht nicht nur darum, gefährlichen Nonsens zu vermeiden. Vielmehr wollen wir spannende neue Geschichten. Wir wollen im CTRL-Projekt Kreativität und neue Ideen. Geht das mit einer Zweitverwertung?

c) Fehlende innere Logik

Die gewünschte Kreativität kann zwar durch Zufall simuliert werden. Wenn zwei für uns unzusammenhängende Informationen in einen direkten Zusammenhang gesetzt werden, sind wir erst einmal überrascht. Wir horchen auf und hören die Geschichte weiter. Aber macht das Zusammengebrachte auch Sinn? Folgt es einer inneren Logik? – Wenn es rein zufällig ist, tut es das nicht, dann fehlt die innere Logik.

Zufall ist nicht Kreativität. Erst wenn ein logischer Zusammenhang zwischen den Zufällen gefunden wird, entsteht eine funktionierende Geschichte. Diese innere Logik fehlt einem corpusbasierten Programm prinzipiell.

Fazit

Daniel Kehlmann hat seine Erfahrungen präzis und gut nachvollziehbar beschrieben. Er erlebte das Experiment als faszinierend und war oft positiv von den Inputs von CTRL überrascht. Trotzdem stellt er fest, dass CTRL entscheidende Schwächen hat und verweist insbesondere auf den fehlenden narrativen Plan, welcher eine Geschichte zusammenhält.

Für jeden, der sich mit künstlicher Intelligenz vorurteilsfrei beschäftigt hat, ist die Erfahrung Kehlmanns eine lebhafte Bestätigung der eigenen Erfahrungen. Ich habe mich beruflich intensiv mit Computerlinguistik beschäftigt, d.h. mit der Frage, wie Computer natürliche Sätze intelligent interpretieren können. Dabei wird klar: Verständnis von Texten baut auf einem inneren Bezugssystem auf. Über dieses Bezugssystem verfügt jeder menschliche Schriftsteller – aber das KI-System nicht. Das korpusbasierte KI-System kennt nur die Wahrscheinlichkeiten von Signalen (Wörtern), ohne ihre wirkliche Bedeutung zu erfassen. Das ist das Problem.

- Zu den Gefahren des corpusbasierten Vorgehens siehe auch:

https://hrstraub.ch/wie-real-ist-das-wahrscheinliche/

Dem KI-System fehlt insbesondere Absicht und Bewusstsein. Die Absicht kann zwar durch die Betreiber von aussen vorgegeben werden – z.B. bestimmte Zellen in einem medizinischen Blutausstrich zu erkennen oder möglichst viel Traffic auf einer Suchmaschine zu erzielen – doch ein wirkliches Bewusstsein eines Programms würde ein Nachdenken über die eigene Absicht beinhalten. Eine corpusbasierte Intelligenz aber denkt überhaupt nicht nach – schon gar nicht über die eigene Absicht – sondern rechnet nur aus, was in seinem Datenpool das Wahrscheinlichste ist.

- Zum Unterschied zwischen künstlicher und natürlicher Intelligenz:

https://hrstraub.ch/kuenstliche-und-natuerliche-intelligenz-der-unterschied/

Das Experiment von Daniel Kehlmann ist deshalb lehrreich, weil es konkret, genau und verständlich Programmierern und Nicht-Programmierern die Grenzen der künstlichen Intelligenz aufzeigt.

Kurzfassung des Fazits

KI ist faszinierend und in vielen Anwendungen ausserordentlich nützlich, aber eines ist künstliche Intelligenz mit Sicherheit nicht: auf kreative Weise wirklich intelligent.

Mehr zu Daniel Kehlmanns und CTRL

- Sendung von SRF2 vom 1. April 2021:

https://www.srf.ch/audio/kontext/kehlmanns-kraeftemessen-mit-kuenstlicher-intelligenz?partId=11955178: - Daniel Kehlmanns «Stuttgarter Zukunftsrede» vom 16. Februar 2021

https://www.swr.de/swr2/literatur/die-erste-stuttgarter-zukunftsrede-autor-daniel-kehlmann-und-sein-algorithmus-experiment-100.html - Die Zukunftsrede als Buch: Mein Algorithmus und Ich, Stuttgarter Zukunftsrede. Klett-Cotta, Stuttgart 2021, ISBN 978-3-608-98480-4.