Entropie: Schlüsselbegriff der Informationstheorie

Entropie ist der Schlüssel, um zu verstehen, was Information bedeutet. Seit Claude Shannons «The Mathematical Theory of Communication» ist evident, dass die Bits der Entropie und die Bits der Information das gleiche messen.

Doch was ist Entropie? Der Zusammenhang zwischen Entropie und Information ist den meisten unbekannt. Gerade deshalb lohnt sich ein genauerer Blick.

Was ist Entropie?

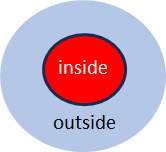

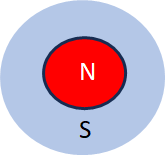

Die gängige Vorstellung von Entropie, nimmt sie als ein Mass für das Chaos. Wie aber kann ein Mass für Chaos ein Mass für Information sein? Chaos und Information sind doch offensichtlich nicht das gleiche! – Das scheinbare Paradox löst sich auf, sobald die moderne Definition von Entropie (nach C.F. von Weizsäcker), zu Grunde gelegt wird. Diese definiert Entropie als Abstand zwischen zwei Beschreibungsebenen:

Was hat Entropie mit Information zu tun?

Der Unterschied zwischen der Beschreibung auf der Mikro- und derjenigen auf Makroebene definiert beides, die Information und die Entropie. Entropie wird dadurch eine relative Grösse, die als Abstand, d.h. als Differenz gemessen und in Bits gemessen werden kann.

Genau das gleiche trifft auf Information zu. Auch Information ist eine relative Grösse, nämlich der Abstand zwischen Wissen und Unwissen:

Entropie ist mehr als Wärmelehre

Der Begriff Entropie stammt ursprünglich aus der Wärmelehre und ergänzt dort den Begriff der Energie. Entropie ist aber viel mehr, nämlich als Informationsentropie nach Claude Shannon auch ein Mass für Information. Die zugehörige Masseinheit ist das Bit. Trotz seiner enormen Bedeutung in der Physik, der Informationstheorie, aber auch im Alltag, gilt der Begriff der Entropie als nerdig und kaum verständlich. Das wäre nicht nötig.

Fünf weit verbreitete Vorurteile erschweren das Verständnis dieses wichtigen Begriffs in der Physik und im Alltag:

Bits und ihr Kontext

In der Informationstheorie gelten Bits als Grundlage der Information. Bits und Entropie hängen eng zusammen, wie Shannon in seinem Schlüsselwerk ‚The Mathematical Theory of Communication‘ aufgezeigt hat.

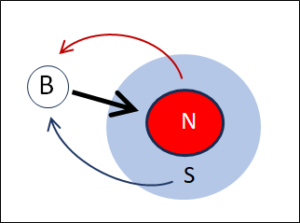

Die Entropie spielt aber auch eine Rolle bei der Beschreibung des Kontexts eines Bits. Erst durch den Einbezug des Kontextes erhalten die Bits ihre Bedeutung. Etwas überspitzt könnte man sagen, dass das Bit ohne seinen Kontext keine Bedeutung hat.

Bits müssen ihre Bedeutung stets von aussen erhalten. Wenn der Kontext unklar ist, ist die Präzision der Bits irreführend. Wenn er klar ist, kann man mit Bits jedoch sehr praktisch rechnen.

Das Bit und die Unterscheidung nach Spencer-Brown

Eine Alternative bezüglich der Behandlung des Kontextes ist der Begriff der Unterscheidung (Distinction) nach Spencer-Brown.

Spencer-Browns Distinction gleicht zwar als binärer Grundbaustein dem Bit, unterscheidet sich von ihm aber dadurch, dass der unlimitierte(!) Kontext in diesen Grundbaustein einbezogen ist. Dadurch wird das Rechnen mit diesem Grundbaustein aber auch schwieriger und deshalb hat er sich in der technischen Welt nicht durchgesetzt – ganz im Gegensatz zum technisch gut isolierbaren und in Kalkulationen perfekt einsetzbaren Bit.

Entropie ist überall

Stanislaw Lem hat in den 70-er Jahren des letzten Jahrhunderts viele Theme der 20-er Jahre dieses Jahrhunderts vorweggenommen. Nicht zuletzt das Thema der künstlichen Intelligenz. Seine philosophischen Überlegungen dazu sind heute topaktuell. Doch auch zur Entropie hat er sich auf originelle Weise geäussert:

Informationsreduktion

Mit der Entropie eng verbunden ist das Phänomen der Informationsreduktion.

Logische Systeme sind immer Vereinfachungen der viel komplexeren und detailhaltigeren Realität. Um zu verstehen, wie wir denken, müssen wir uns mit dieser notgeborenen und unausweichlichen Beschränkung unseres Wissens um die Realität abfinden. Zu diesem natürlichen Vorgang der Informationsreduktion habe ich ab 2019 eine kleine Beitragsserie geschrieben:

Das Thema der Informationsreduktion irritiert viele, doch wir befinden uns damit auf den Spuren von zwei der wichtigsten europäischen Philosophen, nämlich von William Ockham (Ockhams Razor) und Sokrates (Ich weiss, dass ich nichts weiss).

Entropie wird in Bits gemessen und ist eine der Grundlagen von Information -> Übersichtsseite Informationstheorie