Zwei Zustände gleichzeitig

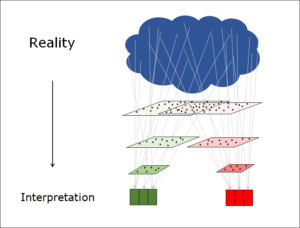

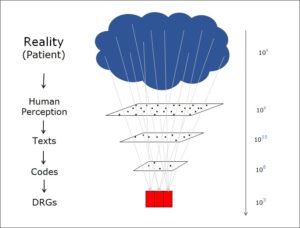

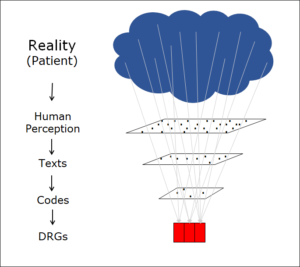

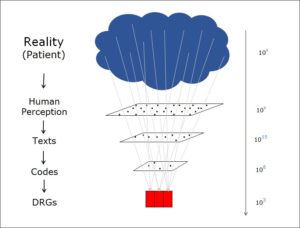

Im Vorbeitrag habe ich dargestellt, wie ein System auf zwei Ebenen beschrieben werden kann, auf der Ebene des Mikro- und auf der des Makrozustandes. Auf der Ebene des Mikrozustandes finden sich alle Detailinformationen, auf derjenigen des Makrozustandes finden sich weniger, dafür stabilere Informationen. Das klassische Beispiel ist das Wasserglas, wo der Mikrozustand die Bewegung der einzelnen Wassermoleküle beschreibt, der Makrozustand dafür die Temperatur der Flüssigkeit kennt. In diesem Beitrag möchte ich darauf eingehen, wie unterschiedlich die Beziehung zwischen Mikro- und Makrozustand sein kann.

Hängt der Makrozustand vom Mikrozustand ab?

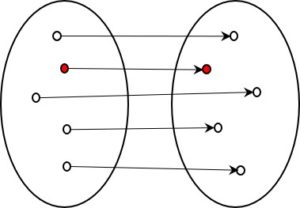

Der Makrozustand ist informatisch, d.h. bezüglich seines Informationsgehaltes, zwar immer kleiner als der Mikrozustand, doch es stellt sich darüber hinaus die Frage, ob er überhaupt eine eigene Existenz hat. Ist er nicht einfach eine Folge des Mikrozustandes? Wie weit ist der Makrozustand durch den Mikrozustand wirklich determiniert? M.E. gibt es in dieser Hinsicht grosse Unterschiede. Das wird deutlich, wenn wir uns überlegen, wie wir die Zukunft der Systeme vorhersagen können:

Wasserglas

Wenn wir die Bewegungsenergien der vielen einzelnen Moleküle kennen, dann kennen wir auch die Temperatur. Das Wissen über den Mikrozustand erlaubt uns, den Makrozustand zu kennen. Wir wissen in diesem Fall auch, wie er sich weiterentwickelt. Wenn das System geschlossen bleibt, dann bleibt die Temperatur konstant. Der Makrozustand bleibt gleich, während im Mikrozustand jede Menge Informationen umher wuseln. Die Temperatur ändert sich erst, wenn Einflüsse von aussen dazu kommen, insbesondere Energieflüsse. Weshalb bleibt die Temperatur gleich? Der Grund liegt im Energieerhaltungssatz. Die Gesamtenergie des geschlossenen Systems bleibt gleich, somit bleibt auch der Makrozustand gleich, wie auch immer die Variablen im Mikrozustand sich ändern.

Weshalb aber gilt der Energieerhaltungssatz? Es bestehen enge Beziehungen zum Hamilton-Prinzip, dem Prinzip der kleinsten Wirkung. Das Hamilton-Prinzip ist eines der grundlegendsten Regeln in der Natur und gilt keinesfalls nur in der Thermodynamik.

Das geschlossene thermodynamische System ist ein ideales System, das so rein in der Natur kaum vorkommt. Es ist real immer nur eine Annäherung. Diesem abstrakten System möchte ich nun einige in der Natur wirklich vorkommende Systeme gegenüber stellen:

Wasserwellen und Bénard-Zellen

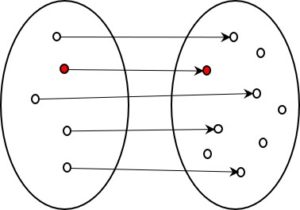

Dieser Typus System lässt sich als Welle auf einer Wasseroberfläche beobachten. In die gleiche Kategorie gehören für mich auch die Bénard-Zellen, über die Prigogine berichtet. In beiden Fällen entstehen die makroskopischen Strukturen als offene Systeme. Wellen und Zellen können nur durch äussere Einwirkungen entstehen, nämlich durch den Temperaturgradienten und die Gravitation bei den Bénard-Zellen und den Wind und die Gravitation bei den Wasserwellen. Die Strukturen entstehen durch das Einwirken dieser äusseren Kräfte, die in ihrem Zusammenspiel die makroskopische Strukturen entstehen lassen, welche interessanterweise über längere Zeit bestehen bleiben. Das Fortbestehen dieser Strukturen erstaunt. Weshalb behält die Welle ihre Form, obwohl immer wieder andere Materieteilchen ihre Grundlage bilden?

Im Unterschied zum isolierten thermischen System sind die in solchen offenen Systemen gebildeten makroskopischen Strukturen wesentlich komplexer. Einander gegenläufige Kräfte von aussen lassen völlig neue Formen – Wellen und Zellen – entstehen. Die äusseren Kräfte sind nötig, damit die Form entstehen und fortdauern kann, aber die entstandene makroskopische Form selber ist neu und nicht bereits in den informatisch (d.h. bezüglich Informationsgehalt) sehr einfachen äusseren Kräften angelegt.

Gleich wie im thermischen System haben wir neben der Makroebene der einfachen äusseren Form (Zelle oder Welle) eine Mikroebene mit den vielen Molekülen, welche z.B. die Form bilden. Und wieder ist die Makroebene, also die Form informatisch wesentlich einfacher als die Mikroebene der vielen Moleküle. Die Welle bleibt in ihrer Form über längere Zeit erhalten, während die vielen Moleküle, die sie bilden, sich wild durcheinander bewegen. Die Welle läuft weiter und erfasst neue Moleküle, welche jetzt die Welle bilden. In jedem Moment erscheint die Form, d.h. das Zusammenkommen des Makrozustandes aus den einzelnen Molekülen vollständig determiniert, aber informatisch viel einfacher erklärbar als durch die vielen Einzelmoleküle ist die Form auf der Makroebene selber, nämlich als einfache Fortsetzung der Welle, einfach mit neuen Molekülen auf der Mikroebene. Es sieht so aus, als wäre der neue Makrozustand am besten erklärbar durch den alten.

Im Gegensatz zu höher entwickelten Formen gilt bei Wasserwellen und Bénard-Zellen: Sobald die Kräfte von aussen nachlassen, verschwindet die Form. Unser Leben ist wie jedes organische aber darauf angewiesen, dass die Formen nicht so schnell verschwinden. Das bedeutet: Der Makrozustand muss gegenüber dem Mikrozustand gestärkt werden.

Der Thermostat

Wir können den Makrozustand stärken, indem wir ihm eine Steuerung beigeben. Denken Sie an eine Heizung mit einem Temperaturfühler. Sobald es kalt wird, wird geheizt, wenn die Temperatur zu hoch wird, hört das Heizen auf. Auf diese Weise wird die Temperatur, d.h. der Makrozustand konstant gehalten. Natürlich ist dieses Heizungssystem thermodynamisch alles andere als geschlossen. Und Temperaturfühler und Steuerung zur Unterstützung und Konstanthaltung des Makrozustandes sind vom Menschen gebaut, entstehen also nicht wie die Wasserwellen auf natürliche Weise. – Oder gibt es so etwas auch in der Natur?

Autopoese und Autopersistenz

Natürlich gibt es solche Steuerungen auch in der Natur. Während meines Medizinstudiums war ich beeindruckt von den vielen und komplexen Steuerungskreisen im menschlichen Organismus. Steuerung hat immer mit Information zu tun. Das Medizinstudium hat mir nahegelegt, Information als wesentlichen Bestandteil der Welt anzusehen.

Man nennt die automatische Entstehung der Welle oder der Bénard-Zelle Autopoese. Welle und Zelle sind aber nicht beständig, die biologischen Organismen jedoch schon, jedenfalls wesentlich beständiger als es die Welle ist. Dies geschieht mit Hilfe von Steuerungen, die Teile des Organismus selber sind. Man muss sich das so vorstellen, als ob eine Welle realisiert, dass sie völlig vom Wind abhängig ist und darauf reagiert, in dem sie die Quelle ihrer Existenz (ihre Nahrung, den Wind) aktiv sucht, bzw. in sich eine Struktur schafft, die seine Energie für die schlechten Zeiten konserviert, wo es nicht weht.

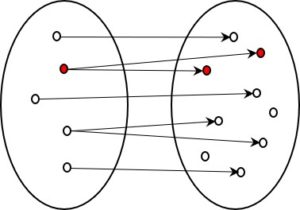

Genau das tut der Körper, jeder biologische Körper. Er ist ein Makrozustand, der sich selber erhalten kann, indem er über Steuerungsvorgänge seinen Mikrozustand kontrolliert und auf die Umwelt reagiert.

Biologische Systeme

Diese Art System unterscheidet sich von isolierten thermischen Systemen durch seine Fähigkeit, Formen entstehen zu lassen und von einfachen, zufällig entstehenden natürlichen Formen wie einer Wasserwelle durch seine Möglichkeit, die Form aktiv überleben zu lassen. Dies ist möglich, da solche biologischen Systeme auf die Umgebung mit dem Ziel reagieren können, ihr Überlebens zu sichern. Von den einfacheren autopoietischen Systemen unterscheidet sich ein biologisches System durch eine länger andauernde Formkonstanz dank komplexen inneren Steuerungen und eine gezielte Aktivität gegenüber der Umgebung.

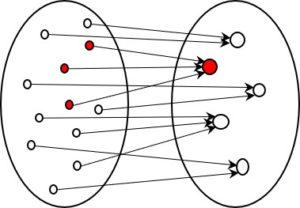

Damit die Formkonstanz möglich ist, braucht es ein wie immer geartetes Gedächtnis, das das Muster bewahrt. Und um auf die Umgebung gezielt zu reagieren, hilft eine wie immer geartete Vorstellung über diese Aussenwelt. Beides, das Gedächtnis für das eigene Muster und die wie auch immer vereinfachte Vorstellung über die Aussenwelt müssen im biologischen System informatisch fixiert sein, sonst kann die Formkonstanz nicht erhalten werden. Das biologische System hat somit einen wie immer gearteten informatischen Innenraum.

Biologische Systeme sind wegen den oben beschriebenen Eigenschaften immer interpretierende Systeme.

Dies ist ein Beitrag aus der Serie Informationsreduktion.