Semantik: Was steckt hinter den Wörtern?

Das Thema Semantik interessiert heute viele Leute. Viele realisieren, dass Wörter nicht alles sind, sondern dass hinter den Wörtern Bedeutungen stecken, die sehr variabel sind und auf die es eigentlich ankommt. Gerade im Internet spielt das eine grosse Rolle. Je grösser das Netz wird, umso schwieriger wird die Suche. Was ist, wenn die gesuchte Adresse unter einem ganz anderen Wort zu finden ist, als ich annehme? Denken wir nur an die vielen Synonyme. Dazu kommen Ober- und Unterbegriffe und unterschiedliche Sprachen. Ideal wäre es, wenn ein sprachunabhängiges System der Bedeutungen existieren würde, ein System, dass Synonyme genauso kennt wie verschiedene Sprachen, Englisch, Französisch, Deutsch, Arabisch, Chinesisch etc. Dann müsste man nur noch die Wörter der jeweiligen Sprache in das semantische System hineinprojizieren. Geht das?

Versuch 1: Semantische Annotation (n:1)

Eine einfache «Semantische Annotation» ist für viele die naheliegende Lösung. Dabei gilt es, jedem Wort seine Bedeutung, d.h. seine eigentliche Semantik, zuzuweisen.

Nehmen wir eine Sprache, z.B. Deutsch und eine Domäne, z.B. Medizin. Das Ziel der semantischen Annotation wäre dann, das gesamte Vokabular der Domäne, also alle ihre Wörter auf eine grundlegende Semantik abzubilden. In dieser existiert dann ein einziger Punkt für den Begriff «Fraktur», und dieser semantische Zielpunkt wird erreicht durch Wörter wie «Fraktur», «Knochenbruch», «fracture», etc. Es handelt sich ja in der Tat um dasselbe, unabhängig davon, welche Wörter ich verwende. Das gilt auch für «Bruch», z.B. in «Beinbruch», «Bruch des Beins», «Bruch der Tibia» und «Bein gebrochen».

Alle diese Formulierungen müssen auf den gleichen semantischen Punkt kommen. Dabei können wir nicht auf die Grammatik gehen, sondern müssen Wörter auseinandernehmen können (Beinbruch), und aus Verben (gebrochen) Substantive machen können. Brüche gibt es viele, solche von Knochen, aber auch von Leisten, Ehen, Implantaten, Brillen etc. Eine einfache Annotation wird daraus kaum werden, sicher keine 1:1 oder n:1 Annotation.

Und wenn verschiedene Fachgebiete gemischt werden, wird es noch heikler: Ein Bruch ist ja nicht nur ein Knochenbruch, sondern auch ein Bruch in der Mathematik. Also etwas ganz anderes. Wie annotiere ich «Zürich»? Als Stadt, als Kanton, als Versicherung? «Berlin» kann je nach Kontext auch für das deutsche Kanzleramt stehen; ein «Berliner» ist ein Bürger oder eine Backware.

Fazit: Eine semantische Annotation ist komplex und ganz gewiss nicht mit einer einfachen n:1 Tabelle lösbar. Um wirklich semantisch zu annotieren, d.h. den Wörtern Bedeutungen zuzuweisen, muss man tiefer in die eigentliche Semantik einsteigen.

Versuch 2: Semantic Web

Initiator des Semantic Webs war der berühmte WWW-Erfinder Tim Berners-Lee. Seine Beobachtung war, dass im WWW die gesuchten Seiten zwar oft vorhanden, aber in der Fülle nicht auffindbar waren. Dem wollte er abhelfen, in dem er das Web selber semantisch machen wollte. Also nicht mehr die Anwender sollten die Semantik (Inhalte) der Internetseiten ergründen, sondern Berners-Lee’s Idee war, dass die Seitenanbieter im WWW ihre Semantik selber deklarieren. Auf diese Weise wäre gesuchte Annotation bereits verhanden. Und zwar nicht einfach als isolierter Punkt, wie «Zürich», sondern typisiert, also z.B. als «Stadt: Zürich». Die Typisierung ist ein echter und zweckmässiger Fortschritt. Der Charme der Typisierung besteht darin, dass die Mehrdeutigkeit angegangen werden. Ob Zürich nun die Stadt, den Kanton oder die Versicherung meint, kann durch ein entsprechend gebautes semantisches Netz klar unterschieden werden.

Das Problem ist nur: Welcher Seitenbetreiber macht sich die Mühe, seine Seite entsprechend semantisch zu verschlagworten? Und das Ganze funktioniert nur, wenn sich alle an das gleiche Einordnungssystem halten. Dazu kommen weitere Probleme, die sehr typisch sind für Versuche, ein semantisches Netz zu bauen. Ein solches Netz zu erstellen ist alles andere als banal, denn der Teufel steckt im Detail.

Und sobald das Netz einmal steht, kann es nicht mehr so einfach verändert werden. Das führt dann schnell zu faulen Kompromissen, Komplizierungen, Unschärfen, Varianten und Diskussionen.

Die grundlegende Frage dabei ist: Wie strukturieren wir das semantische Netz? Ich meine die abstrakte formale Struktur. Gibt es Oberbegriffe? Eigenschaften? Überschneidungen? Wie werden sie formal dargestellt? Gibt es eine «Logik» in der Semantik? Wir sind hier im Kern der wissenschaftlichen Semantik und meine Behauptung ist, dass die Scientific Community hier noch einiges dazuzulernen hat. Das Semantic Web basiert z.B. auf der RDF und OWL, zwei komplexen formalen Sprachen, welche kompliziert, unhandlich und trotzdem in ihren Möglichkeiten beschränkt sind.

Wenn die Annotation von den Seitenanbietern durchgeführt wird, können wir wegen des dafür nötigen Aufwands keine Durchgängigkeit und auch keine Einheitlichkeit erwarten.

Ideal wäre eine Software, welche die semantische Interpretation selbstständig und von aussen, also auf vorbestehende und frei formulierte Texte durchführen kann. Gibt es die? –

Die Antwort ist ja. Es gibt sogar zwei Herangehensweisen, die eine ist statistisch, die andere ist semantisch. Schauen wir zuerst die statistische an:

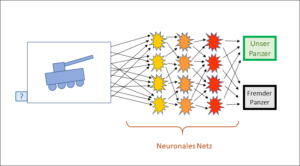

Versuch 3: Neuronale Netze (KI)

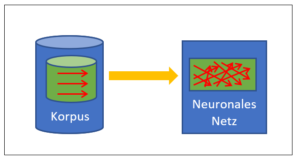

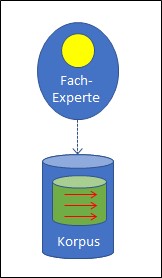

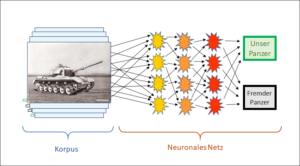

Neuronale Netze (NN) sind besser bekannt unter dem Namen «Künstliche Intelligenz«. Diese Systeme funktionieren über einen Lernkorpus, der viele Muster von Zuweisungen enthält, die vom NN maschinell auf raffinierte Weise integriert werden. Anschliessend ermöglicht das NN weitere, bisher unbekannte Inputs auf die gleiche Weise zu verarbeiten wie im Lernkorpus. Es hat also die Interpretation «gelernt». Das kann sehr beeindruckend sein, und auch sehr nützlich. Allerdings kann das NN nichts wiedergeben, was nicht im Lernkorpus auf ähnliche Weise vorgegeben war. Die bekannten Schwächen der NN sind:

– Riesiger Lernkorpus nötig.

– Nur was im Korpus enthalten ist, kann erkannt werden.

– Seltenes mit grossen Auswirkungen (Black Swan) wird übersehen.

– Intransparenz der Schlüsse.

– Fehler im Korpus sind kaum korrigierbar.

Trotzdem sind Neuronale Netze für viele Anwendungen unglaublich effizient. Doch sie sind nicht semantisch. Sie urteilen nicht nach den Bedeutungen der Wörter, sondern nach statischen Gesichtspunkten. Was häufig zusammen vorkommt, gehört für sie zusammen. Das ist natürlich alles andere als sicher. Seltenere Bedeutungen fallen so unter den Tisch. Und was bedeuten die Wörter und Sätze überhaupt? Neuronale Netze zeigen nur statistische Nähe und überlassen die Bedeutungen dem Leser. Formale Musterekennung ist eine Stärke der Neuronalen Netze. Semantik nicht. Die Lösungen von Versuch 2, das Semantic Web der RDFs and OWL waren da schon näher dran.

Allerdings: In der Praxis haben die NN der kommerziellen Software-Anbieter die akademisch fundierten Versuche des Semantic Webs deutlich überholt. Die NN sind zwar nicht semantisch, aber sie sind im gegensatz zum Semantic Web real einsetzbar.

Ideal wäre jedicg eine Lösung, welche die Bedeutungen der Wörter auf eine ähnliche Weise findet, wie wir Menschen. Also ein Ansatz, der wirklich semantisch ist. Gibt es diesen?

Versuch 4: Begriffsmoleküle (BM)

Begriffsmoleküle sind eine Parallelentwicklung zum Semantic Web. Wie dieses setzen sie eine semantische Modellierung der anvisierten Wissensdomäne voraus. Der Unterschied liegt in der Art, wie die Semantik modelliert wird und wie Schlüsse gezogen werden. Sowohl das OWL des Semantic Web wie die alternativen Begriffsmoleküle sind regelbasiert, im Gegensatz zu den Neuronalen Netzen der KI, die korpusbasiert sind. Als regelbasierte Systeme sind OWL und BM transparent und können Schritt für Schritt untersucht werden. Ihre Begriffe zeigen eine klare Anordnung (semantische Architektur). Ihre Schlüsse sind formal geregelt. Das ist die Gemeinsamkeit. Der Unterschied liegt in der Art der semantischen Architektur und der Art der Schlussziehung (Inferenzmechanismus). Generell lässt sich sagen, dass die BM freier und offener sind als OWL.

Wie ist es möglich, eine freie und dynamische Semantik darzustellen und dabei so formal zu bleiben, dass unsere Gedanken für eine Maschine nachvollziehbar ist? Begriffsmoleküle versuchen genau das. Es geht dabei darum, zu modellieren, wie wir den gehörten Wörtern Bedeutungen zulegen.

Dies ist ein Beitrag zum Thema Semantik.