Das Bit ist die Basis der IT

Unsere Informationstechnologie baut auf dem Bit auf. Alles, was in unseren Computern geschieht, basiert auf diesem kleinsten Basiselement der Information. Wenn Sie gefragt werden, was ein einzelnes Bit bedeutet, werden Sie möglicherweise antworten, dass das Bit zwei Zustände einnehmen kann, von denen der eine 0 ist und der andere 1 bedeutet. Auf diese Weise können wir bekanntlich beliebig hohe Zahlen schreiben, wir müssen einfach genügend Bits hintereinander reihen.

Aber stimmt das auch? Bedeutet wirklich der eine Zustand im Bit 0 und der andere 1? Können die beiden Zustände nicht auch ganz andere Bedeutungen annehmen?

Dem Bit können beliebige Bedeutungen zugeschrieben werden

In der Tat können die beiden Zustände des Bits irgendeine Bedeutung einnehmen. Beliebt sind neben 0/1 auch Wahr/Falsch, Ja/Nein, Positiv/Negativ, aber im Prinzip und in der Praxis können dem Bit von aussen irgendwelche Bedeutungen zugeschrieben werden. Selbstverständlich sind auch Umkehrungen erlaubt, also neben 0/1 auch 1/0.

Die Zuschreibung der Bedeutung des Bits erfolgt von aussen

Ob das konkrete Bit im Computerprogramm nun 0/1 oder 1/0 oder irgendetwas anderes bedeutet, spielt selbstverständlich eine entscheidende Rolle. Die Bedeutung liegt aber nicht im Bit selber, denn das Bit ist eine höchst radikale Abstraktion. Es sagt nur aus, dass zwei Zustände existieren und welcher zur Laufzeit gerade aktuell ist. Was die beiden aber bedeuten, ist eine ganz andere Geschichte, die über das einzelne Bit weit hinausgeht. In einem Computerprogramm kann z.B. deklariert werden, dass das Bit dem Wertepaar TRUE/FALSE entspricht. Das gleiche Bit kann aber auch mit anderen Bits zusammen als Teil einer Zahl oder eines Buchstabencodes interpretiert werden – sehr unterschiedliche Bedeutungen also, je nach Programmkontext.

Digitaler und analoger Kontext

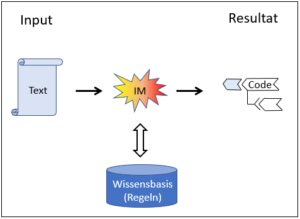

Das Softwareprogramm ist der digitale Kontext und er besteht selbstverständlich aus weiteren Bits. Diese Bits aus der Umgebung können verwendet werden, um die Bedeutung eines Bits zu bestimmen. Nehmen wir an, unser Bit sei mit weiteren Bits daran beteiligt, den Buchstaben ‚f‘ zu definieren. Unser Programm sei auch so organisiert, dass dieser Buchstabe in eine Tabelle zu stehen kommt, und zwar in eine Spalte, die mit ‚Geschlecht‘ überschrieben ist. All dies ist in der Software klar geregelt. Legt nun die Software die Bedeutung des Bits fest? Sicher sind Sie nicht überrascht, wenn das ‚f‘ die Bedeutung ‚feminin‘ hat und die Tabelle vermutlich verschiedene Personen auflistet, die männlich oder weiblich (f) sein können. Was aber bedeuten männlich und weiblich? Erst in der analogen Welt bekommen diese Ausdrücke eine Bedeutung.

Das Bit, die perfekte Abstraktion

Das Bit stellt in der Tat den Endpunkt einer radikalen Informationsabstraktion dar. Die Information ist im einzelnen Bit soweit auf das absolut Elementare reduziert, dass die Information über die Bedeutung aus dem Bit vollständig herausgenommen worden ist. Das Bit sagt nur noch aus, dass zwei – ausserhalb des Bits beschriebene – Zustände existieren und welcher der beiden zu einem bestimmten Zeitpunkt aktuell ist.

Diese radikale Abstraktion ist gewollt und in einer Software sehr sinnvoll. Denn so kann das gleiche physische Bit im Chip des Computer immer wieder neu verwendet werden, einmal als TRUE/FALSE-Paar, einmal als 0/1, einmal als JA/NEIN usw. Das ist sehr praktisch und ermöglicht dem Computer, beliebige Aufgaben zu erfüllen. Die dadurch gewonnene perfekte Abstraktion nimmt dem einzelnen Bit aber gleichzeitig seine individuelle Bedeutung und diese kann und muss dann für jede Anwendung von aussen neu gegeben werden.

Der unendliche Regress

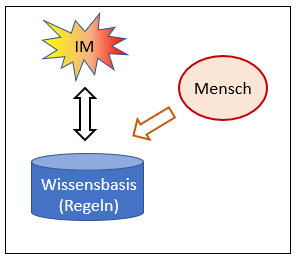

Wenn die Bedeutung des Bits von aussen gegeben wird, dann können natürlich andere Bits diese Aufgabe übernehmen und die Bedeutung des einen Bits definieren. Dazu müssen aber diese äusseren Bits die entsprechende Wirkkraft haben, die natürlich nicht ohne deren eigenen Bedeutung zu haben ist. Und selbstverständlich liegen die Bedeutungen der Bits dieses äusseren Kreises nicht in diesen Bits selber – aus den gleichen Gründen wie oben – sondern sie müssen von aussen, d.h. von einem weiteren Kreis von Bits gegeben werden. Die Bits dieses zweiten äusseren Kreises müssen in einem weiteren Kreis erklärt werden und die Bedeutung der Bits dieses weiteren Kreises wiederum von einem noch äusseren … Selbstverständlich kommt dieser Prozess der Bedeutungszuordnung in einer Welt von Bits nie an sein Ende, der Regress ist unendlich.

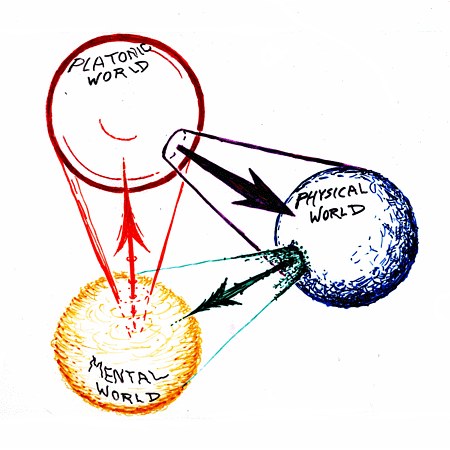

Erst im Analogen endet der unendliche Regress

Erst wenn wir aus dem Programm in die Realwelt heraustreten, können wir den Informationen aus dem Computer wirkliche eine Bedeutung zuordnen.

Selektiver und deskriptiver Informationsgehalt

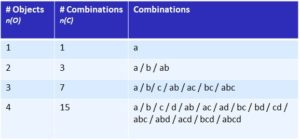

Wenn wir das oben Beschriebene rekapitulieren können wir im Bit Folgendes unterscheiden:

Der deskriptive Informationsgehalt sagt aus, was das Bit bedeutet, er beschreibt die beiden Zustände des Bits, sagt aber nicht aus, welcher Zustand aktuell gewählt ist. Der selektive Informationsgehalt andererseits sagt aus, welcher der beiden Zustände aktuell ist, weiss aber nichts über die Eigenschaften der beiden Zustände, und somit auch nichts über ihre jeweilige Bedeutung.

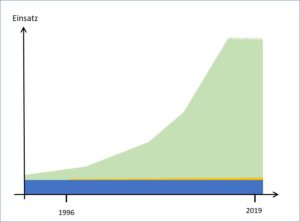

Die Unterscheidung zwischen selektivem und deskriptivem Informationsgehalt wurden vom britischen Radar-Pionier und Informationswissenschaftler Donald McKay in den 40-er Jahren des letzten Jahrhunderts geprägt, praktisch gleichzeitig mit der ersten Erwähnung und Beschreibung des klassischen Bits durch den Amerikaner Shannon. McKay hat auch bereits sehr klar erkannt, dass das Bit von Shannon nur einen selektiven Informationsgehalt trägt und der deskriptive muss von aussen gegeben werden.

Erstaunlicherweise ist diese Erkenntnis von McKay heute beinahe in Vergessenheit geraten.

Fazit:

1. Das Bit liefert den selektiven Informationsgehalt.

2. Der deskriptive Informationsgehalt liegt nicht im Bit.

3. Das Bit hat allein somit auch keine Bedeutung.

4. Die Bedeutung des Bits wird stets von aussen gegeben.

5. Dadurch wird ein unendlicher Regress initiiert.

6. Erst im Analogen endet der unendliche Regress.

Mehr zum Thema Information -> Übersichtsseite Informationstheorie